Open AIやGoogleなどといった競合に対抗するべく、Stable Diffusion 3(SD3)を発表したStability AI。最新かつ最強の画像生成AIモデルとされているSD3は、「Diffusion Transformers」に基づいた新しいアーキテクチャを採用し、さまざまなハードウェアで動作する。

Open AIのDALL-E3などに代表される、今日のAI由来のメディア生成のほとんどが画像や動画、スピーチ、音楽、3D、メッシュ、アートワークなどの出力でDiffusionプログラムに依存している。

Diffusionとは拡散という意味があり、画像などといったメディアに認識できなくなるまで「ノイズ」を加え、画像が完全にノイズ化するまでこれを繰り返すことによって、ノイズ化されたメディアのデータセットを構築する。

この過程を学習したDiffusionモデルは、逆にノイズを徐々に取り除き、段階を経てメディア(新画像)の出力を学ぶというもの。また、通常のDiffusionモデルのバックボーンとなるのがU-Netと呼ばれるもので、除去すべきノイズの推定を学習するものの、複雑で特別にデザインされたモジュールであるために、Diffusionパイプラインを大幅に減速させてしまう特性がある。

ニューラルネットワークの一種であるTransformerは、2017年に登場。複雑な推論タスクの処理に使われるアーキテクチャで、GPT-4やGemini、ChatGPTにも使用されているモデルだ。

ニューラルネットワークの一種であるTransformerは、2017年に登場。複雑な推論タスクの処理に使われるアーキテクチャで、GPT-4やGemini、ChatGPTにも使用されているモデルだ。

最も特徴的なものがAttention機構と呼ばれるもので、インプットされるすべてのデータ(Diffusionでは画像ノイズ)を他の全インプットデータと関連性を評価して、新たな生成のためにデータを引き出すという仕組み。

このAttention機構によって、Transformerが他のアーキテクチャモデルよりもシンプルになるばかりでなく、並列化も可能に。つまり、計算処理を並列化できるため、大量のデータを高速に計算できるというもの。大規模なデータセットを取り扱う上で、このスピードと処理能力は非常に有用である。

また、幸運にもDiffusionモデルのバックボーンでありながら、重荷となっていたU-NetをTransformerに置き換えることが可能であり、効率とパフォーマンスを大幅に向上させられることは大きい。

「TransformerがDiffusionプロセスに寄与するのはいわばエンジンアップグレードのようなもの」と前述のXie氏はTechCrunchのメールでのインタビューに回答。Transformerの導入によって、スケーラビリティと効果が大幅に向上したとしている。

「TransformerがDiffusionプロセスに寄与するのはいわばエンジンアップグレードのようなもの」と前述のXie氏はTechCrunchのメールでのインタビューに回答。Transformerの導入によって、スケーラビリティと効果が大幅に向上したとしている。

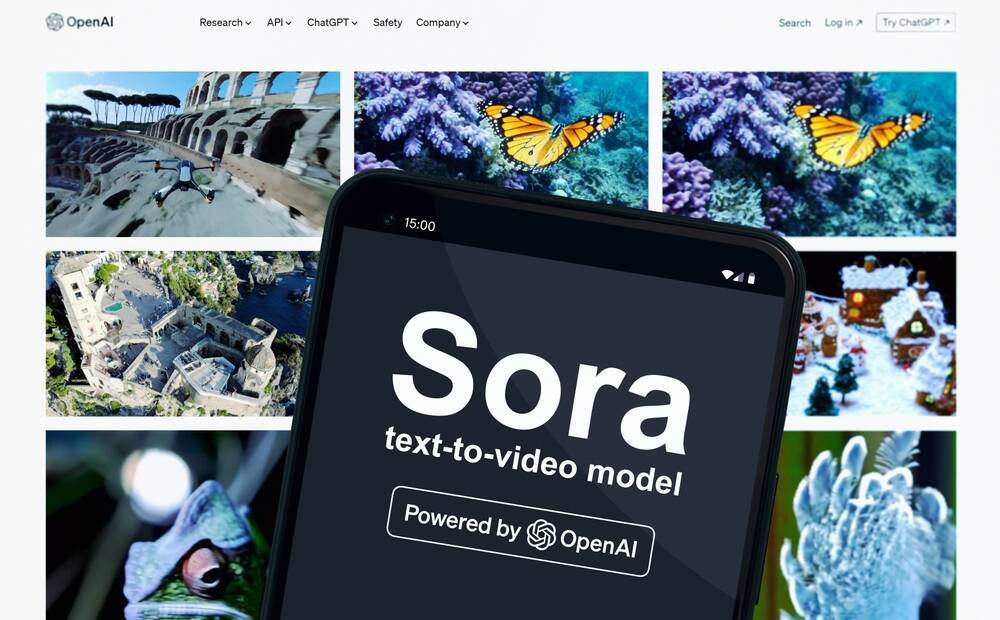

つい最近、デモ動画が日本でも大きな話題となったOpenAIのSoraの登場は、動画AIモデルの領域に再び注目を集めた。

すでにスタートアップのRunwayやPika、Stability AIがAI動画生成モデルを提供し、GoogleがLumiereの力を見せつける中での登場であったが、その画素の鮮明さやスムーズな動き、人体や実世界に基づいた背景の正確さ、そして何よりも動画の「60秒」という長さにおいて群を抜いた技術を見せている。PikaやRunwayが生成する動画の4秒(延長オプション有り)と比較してもその長さは歴然だ。

Soraはさらに、幻想的な動画だけでなく、人々の日常のありふれた風景をリアルに再現生成し、その能力の高さを示している。

Soraが世間を驚かせてから間もなく、Stability AIがStable Diffusion 3(SD3)を発表した。SD3が採用しているのはDiffusion Transformersに基づいた新しいアーキテクチャで、Soraと同様の原理。これにFlow Matchingという新しい技術を採用、過度な負荷を加えることなく生成の品質向上を可能にしている。

Soraが世間を驚かせてから間もなく、Stability AIがStable Diffusion 3(SD3)を発表した。SD3が採用しているのはDiffusion Transformersに基づいた新しいアーキテクチャで、Soraと同様の原理。これにFlow Matchingという新しい技術を採用、過度な負荷を加えることなく生成の品質向上を可能にしている。

SD3が採用している改訂版Diffusion Transformersは、8億(SD1.5よりも少ない)から80億(SD XLより多い)のパラメータ範囲の各種モデルで提供される予定で、多様なスペックのハードウェアで利用が可能。もちろん、本格的なGPUや機械学習作業を目的としたセットアップが必要ではあるものの、Open AIやGoogleのモデルのようにAPIに制限されることはないとされる。

Stable Diffusionを開発するStability AIのCEOはX(旧Twitter)で、この新しいモデルがマルチモダリティで動画のインプットと生成が可能であると言及。APIを軸に展開するOpen AIやGoogleを明らかに意識したものだということがわかる。

これらのモデルはまだ完全にリリースされていないため、比較するのは不可能だが、専門家はStable Diffusionに明らかなアドバンテージがあるとしている。それはあらゆる画像の生成をどこでもできる、方法やコンテンツに本質的な制約がほとんどないこと。これを武器にStable Diffusionは、専門的なニッチの存在よりも、無くてはならないホワイトレーベル生成系AIを目指していると見られている。

同社は使い勝手を重視したツーリングのアップグレードもしていると発表しているものの、詳細はまだ明らかになっていない。

なおSoraのチーム同様にSD3もまた安全性に言及し、強調していることが興味深いと専門家は指摘している。

悪意のあるSD3の誤用を防ぐために、これからも適正な措置を講じていく、とした上で「安全は弊社のモデルのトレーニングの時点から始まり、テスト中、評価、実装の場面でも継続して実施している」と宣言。今回の先行プレビュー版発表に際しても、数多くの安全対策を実施しており、研究者や専門家、コミュニティと継続的に協業し、今後モデルの一般公開に向けて誠意をもって更なる革新を遂げるとしている。

このアプローチを使うことによって、情報が画像とテキストトークンの双方を行き来することができ、アウトプットが生成されるの際の全体的な理解とタイポグラフィを改善できるというもの。さらにこのアーキテクチャは、動画などの複数のモダリティへと拡張することができる。

改善されたプロンプトによって、Diffusion Transformersが複雑な内容やディテール、高品質の画像を生成することに優れた能力を発揮する一方で、Flow Matchingという新技術もSD3には欠かせない技術だ。Flow Matchingは比較的最近のフレームワークであり、生成系モデルの訓練に使われるもの。Diffusion ベースのモデルと比較して学習が容易である一方、実験的パフォーマンスで、優れた性能を見せている。

さらに、Inference(推論)での47億パラメータというメモリー負荷の高いT5テキストエンコーダーを排除することによって、パフォーマンスの劣化を最小限にとどめたままでメモリー要件を大幅に減少することにも成功。このテキストエンコーダーを排除したことによる比較では、ビジュアルの美しさは失われず(T5有りの場合と比較して50%、同等)、テキストの忠実性はわずかに失われた程度(46%)であった。

ただし同社は、テキスト生成にSD3をに活用する際には、T5を排除しないことを推奨。長文や詳細が多く含まれる複雑な文章を用いた場合、タイポグラフィ生成が対38%という大幅なパフォーマンスの低下が見られたからだとしている。

Diffusion Transformerが開発されてからしばらく経って、SoraやStable Diffusion 3が発表されているのはなぜだろうか。前述のXie教授は、スケーラブルなバックボーンのモデルの重要性がつい最近まで明るみに出なかったためだとしている。

Diffusion Transformerが開発されてからしばらく経って、SoraやStable Diffusion 3が発表されているのはなぜだろうか。前述のXie教授は、スケーラブルなバックボーンのモデルの重要性がつい最近まで明るみに出なかったためだとしている。

Soraを構築したチームは、このアプローチを通じてさらに上を目指し、より大きなスケールで何ができるかを示そうとしているとのこと。明らかに、DiffusionからU-Netは去ることとなり、Transformerが置き換わるとしている。

モデルが生成するものが画像であろうと、動画であろうと、オーディオやその他のどんなメディアであっても、Diffusion Transformersが既存のDiffusionモデルとシンプルに差し替えられるべきものであるとしている。現在、Diffusion Transformersの学習プロセスには、効率の悪さやパフォーマンスの低下の可能性があるものの、長期的に対処可能だとXie氏は見ている。

Xie氏はまた「主要な点はシンプルに、U-Netを捨てて、より迅速で、性能が良く、スケーラブルであるTransformerに切り替えること。Diffusion Transformersのフレームワーク内で、コンテンツの理解と創造のドメインを統合させることに興味がある。現在この2つの世界~理解という世界と創造という世界~はまったく異なるものの、将来的にはこの2つの側面が統合する未来を思い描いている」としている。

この統合を達成するためには、基礎となるアーキテクチャの標準化が必要である、と述べこの目的に関してはTransformerが理想的な候補であると言及した。

今後、生成系AIの主流になると予想されるDiffusion TransformersとFlow Matching、新技術の素早い進化にますます目が離せない。

文:伊勢本ゆかり

編集:岡徳之(Livit)

このDiffusion Transformersとはどのようなアプローチなのだろうか。

2022年には存在していたDiffusion Transformers

今話題となっているDiffusion Transformersそのものは、2022年夏にAIリサーチ研究のシーンに登場したAIモデルアーキテクチャ。ニューヨーク大学のコンピュータサイエンス教授のXie氏が、当時MetaのAIリサーチラボでインターンをしていたPeebles氏(Xie氏がメンター)と共に、機械学習上の2つの概念「Diffusion」と「Transformer」を組み合わせたものだ。Open AIのDALL-E3などに代表される、今日のAI由来のメディア生成のほとんどが画像や動画、スピーチ、音楽、3D、メッシュ、アートワークなどの出力でDiffusionプログラムに依存している。

Diffusionとは拡散という意味があり、画像などといったメディアに認識できなくなるまで「ノイズ」を加え、画像が完全にノイズ化するまでこれを繰り返すことによって、ノイズ化されたメディアのデータセットを構築する。

この過程を学習したDiffusionモデルは、逆にノイズを徐々に取り除き、段階を経てメディア(新画像)の出力を学ぶというもの。また、通常のDiffusionモデルのバックボーンとなるのがU-Netと呼ばれるもので、除去すべきノイズの推定を学習するものの、複雑で特別にデザインされたモジュールであるために、Diffusionパイプラインを大幅に減速させてしまう特性がある。

最も特徴的なものがAttention機構と呼ばれるもので、インプットされるすべてのデータ(Diffusionでは画像ノイズ)を他の全インプットデータと関連性を評価して、新たな生成のためにデータを引き出すという仕組み。

このAttention機構によって、Transformerが他のアーキテクチャモデルよりもシンプルになるばかりでなく、並列化も可能に。つまり、計算処理を並列化できるため、大量のデータを高速に計算できるというもの。大規模なデータセットを取り扱う上で、このスピードと処理能力は非常に有用である。

また、幸運にもDiffusionモデルのバックボーンでありながら、重荷となっていたU-NetをTransformerに置き換えることが可能であり、効率とパフォーマンスを大幅に向上させられることは大きい。

Soraのデモ版が見せたAIの進化の速度

つい最近、デモ動画が日本でも大きな話題となったOpenAIのSoraの登場は、動画AIモデルの領域に再び注目を集めた。

すでにスタートアップのRunwayやPika、Stability AIがAI動画生成モデルを提供し、GoogleがLumiereの力を見せつける中での登場であったが、その画素の鮮明さやスムーズな動き、人体や実世界に基づいた背景の正確さ、そして何よりも動画の「60秒」という長さにおいて群を抜いた技術を見せている。PikaやRunwayが生成する動画の4秒(延長オプション有り)と比較してもその長さは歴然だ。

Soraはさらに、幻想的な動画だけでなく、人々の日常のありふれた風景をリアルに再現生成し、その能力の高さを示している。

高架を走る電車の車内から眺める街の風景などは車窓の向こう側に町の風景、ガラスには社内の風景が映り込むといったリアルさ。東京の桜と雪の風景や雨上がりの夜景を女性が歩くデモ版を公表したSoraだが、レッドチームの作業やセキュリティの問題をクリアする必要があるとして、現時点では限られた数のクリエイターのみに公開中としている。

Stable Diffusion 3の登場

SD3が採用している改訂版Diffusion Transformersは、8億(SD1.5よりも少ない)から80億(SD XLより多い)のパラメータ範囲の各種モデルで提供される予定で、多様なスペックのハードウェアで利用が可能。もちろん、本格的なGPUや機械学習作業を目的としたセットアップが必要ではあるものの、Open AIやGoogleのモデルのようにAPIに制限されることはないとされる。

Stable Diffusionを開発するStability AIのCEOはX(旧Twitter)で、この新しいモデルがマルチモダリティで動画のインプットと生成が可能であると言及。APIを軸に展開するOpen AIやGoogleを明らかに意識したものだということがわかる。

これらのモデルはまだ完全にリリースされていないため、比較するのは不可能だが、専門家はStable Diffusionに明らかなアドバンテージがあるとしている。それはあらゆる画像の生成をどこでもできる、方法やコンテンツに本質的な制約がほとんどないこと。これを武器にStable Diffusionは、専門的なニッチの存在よりも、無くてはならないホワイトレーベル生成系AIを目指していると見られている。

同社は使い勝手を重視したツーリングのアップグレードもしていると発表しているものの、詳細はまだ明らかになっていない。

ただし利用者のハードルを低くすることで、更なるユーザーの拡大を目論んでいることは確実だ。

なおSoraのチーム同様にSD3もまた安全性に言及し、強調していることが興味深いと専門家は指摘している。

悪意のあるSD3の誤用を防ぐために、これからも適正な措置を講じていく、とした上で「安全は弊社のモデルのトレーニングの時点から始まり、テスト中、評価、実装の場面でも継続して実施している」と宣言。今回の先行プレビュー版発表に際しても、数多くの安全対策を実施しており、研究者や専門家、コミュニティと継続的に協業し、今後モデルの一般公開に向けて誠意をもって更なる革新を遂げるとしている。

2つの新技術と今後の期待

同社のリサーチペーパーによると、SD3の最大の特徴である新技術は、Diffusion Transformersの中でもMultimodal Diffusion Transformerと呼ばれるアーキテクチャだ。テキストとイメージ用にそれぞれ別のウェイトを使用することで、2つのモダリティごとに独立したTransformersを使用しているのと同じ状態になる。その一方、Attention機構で2つのモダリティを組み合わせることによって、お互いを考慮しながらそれぞれの領域で作動できる。これが、Multimodalと呼ばれる理由だ。

このアプローチを使うことによって、情報が画像とテキストトークンの双方を行き来することができ、アウトプットが生成されるの際の全体的な理解とタイポグラフィを改善できるというもの。さらにこのアーキテクチャは、動画などの複数のモダリティへと拡張することができる。

改善されたプロンプトによって、Diffusion Transformersが複雑な内容やディテール、高品質の画像を生成することに優れた能力を発揮する一方で、Flow Matchingという新技術もSD3には欠かせない技術だ。Flow Matchingは比較的最近のフレームワークであり、生成系モデルの訓練に使われるもの。Diffusion ベースのモデルと比較して学習が容易である一方、実験的パフォーマンスで、優れた性能を見せている。

さらに、Inference(推論)での47億パラメータというメモリー負荷の高いT5テキストエンコーダーを排除することによって、パフォーマンスの劣化を最小限にとどめたままでメモリー要件を大幅に減少することにも成功。このテキストエンコーダーを排除したことによる比較では、ビジュアルの美しさは失われず(T5有りの場合と比較して50%、同等)、テキストの忠実性はわずかに失われた程度(46%)であった。

ただし同社は、テキスト生成にSD3をに活用する際には、T5を排除しないことを推奨。長文や詳細が多く含まれる複雑な文章を用いた場合、タイポグラフィ生成が対38%という大幅なパフォーマンスの低下が見られたからだとしている。

U-NetからTransformerへ

Soraを構築したチームは、このアプローチを通じてさらに上を目指し、より大きなスケールで何ができるかを示そうとしているとのこと。明らかに、DiffusionからU-Netは去ることとなり、Transformerが置き換わるとしている。

モデルが生成するものが画像であろうと、動画であろうと、オーディオやその他のどんなメディアであっても、Diffusion Transformersが既存のDiffusionモデルとシンプルに差し替えられるべきものであるとしている。現在、Diffusion Transformersの学習プロセスには、効率の悪さやパフォーマンスの低下の可能性があるものの、長期的に対処可能だとXie氏は見ている。

Xie氏はまた「主要な点はシンプルに、U-Netを捨てて、より迅速で、性能が良く、スケーラブルであるTransformerに切り替えること。Diffusion Transformersのフレームワーク内で、コンテンツの理解と創造のドメインを統合させることに興味がある。現在この2つの世界~理解という世界と創造という世界~はまったく異なるものの、将来的にはこの2つの側面が統合する未来を思い描いている」としている。

この統合を達成するためには、基礎となるアーキテクチャの標準化が必要である、と述べこの目的に関してはTransformerが理想的な候補であると言及した。

今後、生成系AIの主流になると予想されるDiffusion TransformersとFlow Matching、新技術の素早い進化にますます目が離せない。

文:伊勢本ゆかり

編集:岡徳之(Livit)

![[医食同源ドットコム] iSDG 立体型スパンレース不織布カラーマスク SPUN MASK 個包装 ホワイト 30枚入](https://m.media-amazon.com/images/I/51m0nKLQ+rL._SL500_.jpg)

![[アイリスオーヤマ] ディスポーザブル 不織布 プリーツ型マスク ふつうサイズ 120枚](https://m.media-amazon.com/images/I/41jEQGK2thL._SL500_.jpg)